Desde el Fondo Nacional del Ahorro

Santiago Martínez, Daniel Jaramillo, Mario F. Jiménez

Santiago Martínez, Daniel Jaramillo, Mario F. Jiménez

La fuerza de la revolución 4.0 se siente en todas las dimensiones de nuestro diario vivir. En encender o apagar las luces mediante el internet de las cosas (IoT), en el uso de plataformas de streaming para ver series o escuchar música, o en una aplicación que te señala el camino más rápido para llegar a tu destino.

Sin embargo, estas son muestras desde nuestro lado como consumidores. Existe otra revolución 4.0 desde el lado empresarial con tecnologías disruptivas que ayudan a una entidad, por ejemplo, con los modelos de predicción, con el procesamiento de lenguaje natural, análisis de datos avanzado y análisis de voz e imágenes. Estos métodos le permiten a una compañía mejorar sus procesos y obtener resultados, muchos de ellos impensables 10 años atrás. Adicionalmente, para su implementación no es necesario un cambio drástico en la estructura informática y humana de la empresa. No obstante, aún existen muchas empresas con amplias cantidades de información en diferentes formatos que desconocen cómo generar valor e impactar positivamente a la comunidad con el uso adecuado de la misma.

Si se quiere que la información genere valor, debe hacerse uso de la ciencia de datos para obtener resultados que lleven a crear planteamientos de nuevas estrategias, productos y/o mejoras en los procesos. Con base en lo expuesto, uno de los pasos más importantes para lograr los resultados necesarios que permitan tomar decisiones basados en información es el desarrollo de un modelo segmentación.

¿Qué es un modelo de segmentación?

Una pregunta fundamental en toda empresa es ¿Quiénes son mis clientes? Respondiendo esta pregunta es donde se esconde el éxito de un negocio, conociendo al cliente. El dueño de un restaurante, por ejemplo, tal vez podría saber que durante el fin de semana a su establecimiento llegan clientes con sus parejas o incluso familias normalmente formadas por 3 y 5 personas. Sin embargo, tiene más clientes entre semana, los cuales son oficinistas que salen a almorzar.

Puede que no lo sepa con certeza, pero el dueño, en ese momento, está haciendo la tarea de segmentar sus clientes. Los dividió en tres grupos: los comensales en pareja, los asistentes en familia y los oficinistas. Al darles estos nombres a los grupos, también los caracteriza. Los segmenta.

Siguiendo con el ejemplo, si el dueño del restaurante conoce los tipos de clientes que tiene, él puede empezar a plantear estrategias que le permitan mejorar el rendimiento de su negocio. Puede ofertar platos especiales según el día de la semana, mejorar la logística interna del espacio cuando los comensales arriban en grupos grandes los fines de semana, y/o concertar con los cocineros para tener todo listo a la hora del almuerzo para los oficinistas. Las anteriores, son estrategias concretas que optimizan los procesos y lo más importante, mejoran el servicio al cliente.

La respuesta que ofrece el dueño del restaurante está muy ligada a los patrones que él, de acuerdo con su experiencia, ha observado. Sin embargo, ¿Realmente es esa división, en 3 categorías, la más adecuada?; ¿Qué pasa si tiene grupos de clientes que no ha logrado observar? Clientes vegetarianos, veganos o con condiciones especiales, por ejemplo ¿Y si los grupos se pueden segmentar aún más? ¿Y si podemos ahondar en sus características? Es aquí donde las técnicas de machine learning entran a jugar un papel importante. Usando estas técnicas se puede identificar patrones en los clientes de manera automatizada y evitar los sesgos.

De manera general, un modelo de segmentación es un algoritmo que nos permite agrupar distintos puntos de un conjunto de datos con base en las características que compartan los diferentes grupos entre sí. Existen varios modelos que con su aplicación pueden ayudar en los ejercicios de segmentación, ahora bien, el desempeño de cada uno de los modelos depende de las particularidades de los conjuntos de datos.

Cómo funciona el modelo de segmentación

El modelo de segmentación funciona en dos fases: la primera fase se denomina clustering. Consiste en agrupar puntos (en este caso clientes) cuyas características sean comunes, centrándose en las variables de interés. Existen múltiples algoritmos que permiten hacer clustering, pero seleccionar el algoritmo adecuado depende de la naturaleza de los datos que se esté manejando y el objetivo con el cual se realiza el ejercicio de clustering; la segunda fase es la caracterización de estos grupos o clústeres, los cuales son obtenidos en la primera fase. La idea es buscar características importantes que permitan diferenciar los segmentos entre sí. la meta es encontrar características que tengan una alta interpretabilidad, y así, enlazar los resultados con estrategias de impacto, medibles y alcanzables.

Como es de esperar, antes de entrar a aplicar algoritmos de clustering, hay un proceso de limpieza y transformación, donde se preparan los datos. Es normal encontrar en las bases de datos campos vacíos, valores mal escritos, valores con magnitudes sin sentido, entre otras particularidades. La limpieza y transformación de datos es uno de los pasos más importantes de la analítica avanzada y al que actualmente se le invierte mayor dedicación.

Una vez los datos estén “limpios”, se seleccionan las variables óptimas para el propósito de la iniciativa. En el ejemplo del restaurante, algunas variables relevantes podrían ser: hora de visita, frecuencia de visita, plato favorito, plato de mayor venta, valor de consumo, entre otras. Al usar estas variables se podrían identificar grupos de clientes con características similares. Ver clientes a los que les guste visitar el restaurante temprano en el día, o con preferencias vegetarianas, o de consumo regular. Sin embargo, también pueden existir variables no relevantes, por ejemplo, el número de cédula, que en este caso no serviría. No tiene sentido hablar del conjunto de clientes cuya cédula está en cierto rango, porque esa característica no necesariamente afecta la forma en que se comportan los clientes.

En nuestro caso particular para el proyecto trabajado en el Fondo Nacional del Ahorro (FNA), en el proceso de clustering, usamos uno de los principales algoritmos existentes de segmentación, el Modelo de Mezcla Gaussiana (Gaussian Mixture Model, GMM). Para el reto abordado, evidenciamos que el modelo recogió adecuadamente la correlación entre las variables analizadas de acuerdo con el comportamiento de los datos, situación que mostró un mejor rendimiento cuando se comparó con un algoritmo tradicional de segmentación k-means. Este escenario permitió articular los resultados con la estrategia de negocio, definir actividades con el objetivo de mejorar tanto los indicadores, como la experiencia del cliente.

En general, los clústeres o las nubes de datos conseguidos con el GMM pueden tener diferentes formas, es decir, pueden ser alargados, planos o esféricos, todo de acuerdo con la distribución gaussiana multivariable implícita en el modelo. Como se mencionó anteriormente, antes de seleccionar GMM como el modelo final, comparamos los resultados obtenidos con el modelo k-means. Para este caso en particular, los resultados del k- means no generaron una clara separación de los grupos que respondiera a nuestra pregunta de negocio: ¿Qué características tienen los clientes que lograron obtener un crédito? y ¿cuáles son las características de los afiliados que aún no tienen crédito en el FNA?, debido a que el algoritmo k-means está diseñado para clusters esféricos pero nuestros datos no se comportan de esa manera. Por el contrario, el modelo GMM logró capturar los segmentos de clientes que eran objeto de estudio y respondían a nuestro objetivo. En conclusión, fue necesario encontrar un modelo que se ajustara a la forma de nuestros datos; que hiciera una separación alineada a la intuición del negocio; y lo más importante, que tuviera una clara interpretación.

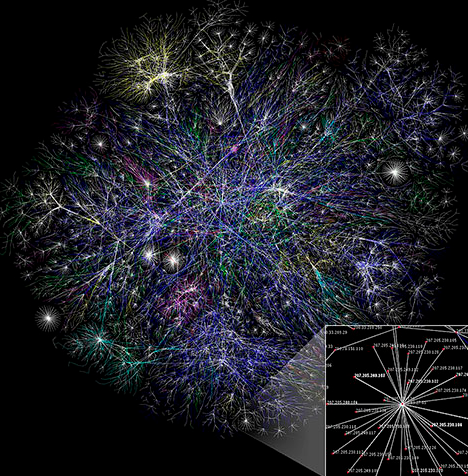

Visualización de una porcion de las rutas del internet - By The Opte Pro...

Visualización de una porcion de las rutas del internet - By The Opte Pro...

Así se hace en la vida real

Hasta este momento, hemos expuesto el caso de manera “ideal”, haciendo uso de una “tubería” (pipeline) muy general, así se aprende en el entorno académico, solo hemos hablado de preparación de datos, algoritmos y su interpretación. En una empresa las aplicaciones son más profundas, y generan la pregunta: ¿Cómo se articulan los resultados con la estrategia y con los objetivos trazados? Es aquí donde el ecosistema se empieza a ampliar y la interacción con equipos multidisciplinarios es necesaria para definir las opciones, actividades, planteamientos y estrategias para la obtención de resultados.

Por lo general, la persona al frente del desarrollo del modelo necesita de un experto de negocio que lo acompañe en su tarea. El analista de datos podrá tener conocimiento sobre algoritmos, limpieza de datos, visualización, entre otros. Esto no significa que conozca todos los cambios normativos o reglas construidas e implementadas a lo largo de los años. De este modo, surge una conexión esencial entre el analista de datos y el experto de negocio. Esa persona entiende el funcionamiento interno de la empresa, es el experto, por lo tanto, verifica que las hipótesis planteadas estén alineadas a la realidad, y que las interpretaciones generadas, sean las correctas.

De la estrecha relación entre el analista de datos y el experto de negocio nacen planteamientos y variables relevantes que son incluidas en los modelos y se articulan con el negocio mediante estrategias. Es así como comienza, se desarrolla e implementa una iniciativa de analítica.

Otro gran aspecto importante es que el conjunto de datos ( dataset) evolucione durante el proyecto con base en los análisis de los resultados inicialmente obtenidos, y también, debido a nuevas preguntas de negocio por responder. En cualquier momento se hace necesario nutrir el dataset con información de bases de datos públicas, usando encuestas, servicios de recolección de información, haciendo extracción de datos de la web ( webscraping), entre otras técnicas. El acceder, procesar y visualizar datos externos es una habilidad fundamental para concluir si variables adicionales, ayudan al modelo en su trabajo. En el FNA, esta es una de las grandes tareas que el grupo de Analítica lleva a cabo.

Hay que tener en cuenta que en el ámbito académico es común aprender sobre el machine learning como herramienta que hace parte de la inteligencia artificial . Estos proyectos normalmente se trabajan durante un semestre y generalmente, no se vuelve a interactuar con ellos jamás. Mientras que, en el ámbito empresarial, los desarrollos nacen para cumplir con un objetivo, evolucionan, se evalúan y calibran, de acuerdo con las necesidades. Los desarrollos surgen para vivir en un ciclo de mejora continua. También brotan nuevas necesidades de negocio todo el tiempo, nuevos datos por incluir o incluso, podrían emerger nuevos algoritmos que dejen a los anteriores obsoletos. Gracias a las aplicaciones de la inteligencia artificial, se logra impactar positivamente a los colombianos que visualizan su sueño de tener vivienda propia, ofreciendo estrategias segmentadas de acuerdo con los momentos de vida y necesidades de los afiliados del FNA. Así es como construimos país, siendo el vehículo que apoya los sueños de los colombianos y ponemos nuestras capacidades al servicio de la sociedad.

RECUADRO

En Colombia hay universidades que suplen de profesionales con habilidades aplicadas a la inteligencia artificial. Entre ellas, la Universidad del Rosario. Forman líderes en innovación. Es el caso particular del estudiante Santiago Martínez Loaiza, quien, cursando el último semestre del pregrado de Matemáticas Aplicadas y Ciencia de la Computación, tuvo la oportunidad de acceder a una pasantía en el FNA, una entidad en la que la revolución 4.0 es pilar estratégico y donde Santiago ha logrado llevar a cabo esos procesos de transformación digital en el mundo real.

En el FNA se han ejecutado diversas iniciativas relacionadas a la revolución 4.0 como la digitalización de trámites, automatización de procesos repetitivos, desarrollo de modelos de aprendizaje de máquina e inteligencia artificial. La experiencia que ofrece la pasantía se llevó a cabo en el Grupo de Analítica de la Entidad donde Santiago ha participado en varias iniciativas.